Dynamic feature extraction for flotation froth based on centroid-convex hull-adaptive clustering

-

摘要: 面对复杂的浮选现场环境及浮选泡沫自身相互粘连导致的边界不清等情况,现有泡沫动态特征(流动速度和崩塌率)提取方法往往无法准确划定属于每个泡沫的动态特征采样区域、不能全面匹配相邻帧间的特征点对且难以有效识别崩塌区域。针对上述问题,提出了一种基于质心−凸包−自适应聚类法的浮选泡沫动态特征提取方法。该方法采用集成Swin−Transformer多尺度特征提取能力的改进型Mask2Former,实现对泡沫质心的精准定位和崩塌区域的有效识别;通过最优凸包评价函数搜寻目标泡沫周围相邻一圈泡沫质心构建的凸包,拟合出接近实际泡沫轮廓的动态特征采样区域;运用基于Transformer的局部图像特征匹配(LoFTR)算法匹配相邻帧图像间的特征点对;针对动态特征采样区域内部的所有特征点对,通过基于OPTICS算法的主特征自适应聚类法提取每个泡沫的主要流动速度。实验结果表明,在普通泡沫质心定位和崩塌区域识别任务中,该方法分别取得了88.83%,97.92%的准确率及77.90%,96.52%的交并比;以2.69%的平均剔除率实现了99.93%的特征点对匹配正确率;在多种工况下均能有效划定与实际泡沫边界相近的特征采样区域,进而定量提取每个泡沫的动态特征。Abstract: In the face of complex flotation site environments and issues such as unclear boundaries caused by the mutual adhesion of flotation froth, existing methods for extracting dynamic features (such as flow velocity and collapse rate) often fail to accurately delineate the dynamic feature sampling regions corresponding to each froth, cannot comprehensively match feature points between adjacent frames, and have difficulty effectively identifying collapse regions. To address these problems, a dynamic feature extraction method for flotation froth based on a centroid-convex hull-adaptive clustering approach is proposed. This method employs an improved Mask2Former, integrated with the multi-scale feature extraction capability of Swin-Transformer, to accurately locate froth centroids and effectively identify collapse regions. An optimal convex hull evaluation function is used to search for the convex hull formed by the centroids of adjacent froth surrounding the target froth, thereby fitting a dynamic feature sampling region close to the actual froth contour. The local feature matching with transformer (LoFTR) algorithm is applied to match feature point pairs between adjacent frames. For all feature point pairs within the dynamic feature sampling region, the main flow velocity of each froth is extracted using the main feature adaptive clustering method based on the OPTICS algorithm. Experimental results show that this method achieves accuracy rates of 88.83% and 97.92% and intersection over union (IoU) rates of 77.90% and 96.52% in ordinary froth centroid location and collapse region identification tasks, respectively. It also achieves a correct feature point pair matching rate of 99.93% with an average exclusion rate of 2.69%. The method effectively delineates feature sampling regions close to the actual froth boundaries under various conditions, enabling the quantitative extraction of each froth's dynamic features.

-

0. 引言

浮选是一种复杂的分选工艺,对浮选过程的量化评价涉及多个关键特征,其中浮选泡沫动态特征(流动速度和崩塌率)对于解析和评估浮选过程尤为重要。泡沫流动速度揭示了矿浆中的矿物含量、pH值和浓度等条件;崩塌率则是评估泡沫稳定性的重要指标。当前浮选现场依赖于操作工人的主观经验估计泡沫动态特征,存在较大的误判风险。运用机器视觉技术实时、准确地从泡沫图像中定量提取泡沫动态特征[1-3],是优化浮选过程、提升浮选精度的关键[4-6]。

在对浮选泡沫动态特征进行量化提取的研究中,识别并划定每个泡沫的动态特征采样区域、尽可能全面地匹配相邻帧图像间的泡沫特征点对、识别图像中的崩塌区域是3个主要的研究难点。在泡沫动态特征采样区域划定方面:文献[7]基于聚类预分割和高低精度距离重构技术,提出了泡沫图像分水岭分割方法;文献[8]运用Retinex进行泡沫光照补偿,引入多尺度几何分析改善泡沫对比度低、受噪声和光照影响等情况,提出了面向参数测量的泡沫图像分割方法;文献[9]设计了一种基于神经网络的泡沫分割算法,通过多尺度特征提取和改进自注意力机制,提高了浮选泡沫图像分割的精度和效率。在相邻帧特征点对匹配方面:文献[10]通过尺度不变特征转换(Scale-Invariant Feature Transform,SIFT)方法,较准确地提取出部分泡沫的速度特征;文献[11]采用限制对比度自适应直方图均衡化(Contrast Limited Adaptive Histogram Equalization,CLAHE)和三维块匹配滤波(Block-Matching and 3D filtering,BM3D)的组合方法对浮选泡沫图像进行预处理,并使用加速KAZE(Accelerated-KAZE,AKAZE)和基于网格的运动统计(Grid-based Motion Statistics,GMS)算法进行特征点对匹配,利用卡尔曼运动估计法对所求的泡沫流动速度进行修正;文献[12]使用抗尺度快速变化和具有旋转不变性的模板匹配算法,并结合宏块跟踪技术和二维拉格朗日曲面插值法,实现了像素级和亚像素级的泡沫流动速度的估计。在崩塌区域识别方面:文献[13]通过比较连续图像中的灰度差异以识别泡沫图像中的崩塌区域;文献[14]通过比较相邻2帧图像特定区域的面积变化,来判断泡沫图像中的崩塌区域。

然而现有浮选泡沫动态特征提取方法存在以下局限:① 在划定泡沫动态特征采样区域时依赖于对泡沫完整边界的分割,这仅适用于具有清晰边界的较大泡沫。在实际工业应用中,恶劣的现场环境及泡沫自身相互粘连的属性使得泡沫往往缺乏清晰的形态学边界,导致通过完整分割所有泡沫边界的方式常出现无法形成封闭动态特征采样区域的情况。② 受光照不均、噪声干扰、设备振动及运动模糊等因素影响,可检测到的相邻帧间特征点对数量有限。③ 工业现场图像采集区域光照变化对图像灰度值造成显著影响,加剧了崩塌区域识别的难度。因此,本文提出了一种基于质心−凸包−自适应聚类法的浮选泡沫动态特征提取方法。该方法通过改进的Mask2Former准确定位所有泡沫质心位置并识别崩塌区域,利用最优凸包评价函数划定每个待求泡沫的动态特征采样区域,运用基于Transformer的局部图像特征匹配(Local Features Matching with Transformer,LoFTR)算法[15]稳定匹配相邻帧特征点对,并结合自适应聚类法提取每个泡沫动态特征采样区域内部的主要流动速度。

1. 方法原理

基于质心−凸包−自适应聚类法的浮选泡沫动态特征提取方法原理如图1所示。泡沫质心分类定位与崩塌区域识别模块通过Swin−Transformer[16]提取泡沫图像的多尺度特征图,训练查询(Query)向量在多尺度特征图中查找所有可能的泡沫质心位置及发生崩塌的区域信息。最优凸包搜寻定域模块通过遍历每个泡沫质心,利用最优凸包评价函数查找由邻近泡沫质心构成的最能拟合此泡沫边界的凸包,通过对凸包区域的缩放获得此泡沫的动态特征采样区域。动态特征点对提取模块采用自注意力和交叉注意力的方式进行相邻帧泡沫图像间信息的交互,并采用由粗粒度至细粒度的特征点对匹配策略全面搜寻相邻帧间特征点对。通过计算特征点对间的距离和偏转角度,结合最优凸包为每个泡沫划定的动态特征采样区域,在划定的边界内部运用主特征自适应聚类模块获得区域内最具代表性的泡沫流动速度。

1.1 泡沫质心分类定位与崩塌区域识别模块

为通过单一网络同时实现不同类型泡沫质心的精确定位及崩塌区域的识别,在Mask2Former[17]的基础上进行改进,选择具有细粒度特征感知能力的Swin−Transformer作为特征提取网络,获得多尺度、多层级的特征表示。借助可学习的Query向量,在像素解码器重构后的多尺度特征图中高效搜寻关键质心位置信息。Transformer解码器部分结合掩码注意力机制,生成掩码图,有效屏蔽背景干扰,聚焦于关键区域。进而,通过解耦输出的方式并行执行类别分类与区域预测任务,通过对掩码图和经过多重注意力层重构的Query进行点积运算,精确识别出多个关键位置,包括散点区域(普通泡沫质心、较小泡沫质心)与成片区域(崩塌区域、不成泡区域等)。

在网络学习过程中,由于普通泡沫质心、较小泡沫质心类型在正常工况下的标签数量会远多于不成泡区域和崩塌区域类型的标签数量,有标签区域的像素数也远小于不存在标签的背景区域的像素数,导致网络很容易倾向于对无标签的背景区域及存在更多数量标签的类别过度学习,掩盖了较少数量标签的类别,不利于整体定位性能。因此,本文设计了一种带权重的联合损失函数,旨在平衡样本类别间的数量差异,提升对稀少类别的识别能力。该损失函数结合了二元交叉熵损失、Dice损失和分类交叉熵损失,其中二元交叉熵损失和Dice损失增强对标签区域的识别能力,分类交叉熵损失优化类别预测的准确性。通过引入类别权重因子,有效缓解类别不平衡问题,增强对于不同类型和不同区域学习的均衡性。此外,对于大多数背景区域无标签的问题,结合PointRend[18]的策略,仅在关键采样点上进行计算,显著降低计算量。

带权重的联合损失函数$ {L}_{\mathrm{T}\mathrm{o}\mathrm{t}\mathrm{a}\mathrm{l}} $为

$$ {L}_{\text {Total }}=\frac{1}{N} \sum_{l=1}^N\left(\lambda_{\mathrm{BCE}} {L}_{\mathrm{BCE}, l}+\lambda_{\text {Dice }} {L}_{\text {Dice }, l}+\lambda_{\mathrm{Cls}} {L}_{\mathrm{Cls}, l}\right) $$ (1) $$ {L}_{\mathrm{BCE}, l}=-\frac{1}{J K} \sum_{j=1}^{J K}\left[m_{l j} \ln\; \hat{m}_{l j}+\left(1-m_{l j}\right) \ln \left(1-\hat{m}_{l j}\right)\right] $$ (2) $$ {L}_{\mathrm{D}\mathrm{i}\mathrm{c}\mathrm{e},l}=1-\frac{2\displaystyle\sum_{j=1}^{J K}{\hat{m}}_{lj}{m}_{lj}}{\displaystyle\sum_{j=1}^{JK}{\hat{m}}_{lj}+\displaystyle\sum_{j=1}^{J K}{m}_{lj}} $$ (3) $$ {L}_{\mathrm{C}\mathrm{l}\mathrm{s},l}=-\displaystyle\sum _{c=1}^{C} {w}_{c}{t}_{lc}\mathrm{l}\mathrm{n}\;{s}_{lc} $$ (4) 式中:$ N $为实例总数;$ {L}_{\mathrm{B}\mathrm{C}\mathrm{E},l}{,{L}}_{\mathrm{D}\mathrm{i}\mathrm{c}\mathrm{e},l}{,{L}}_{\mathrm{C}\mathrm{l}\mathrm{s},l} $分别为第$ l $个实例的二元交叉熵损失、Dice损失和分类交叉熵损失函数;$ {\lambda }_{\mathrm{B}\mathrm{C}\mathrm{E}},{\lambda }_{\mathrm{D}\mathrm{i}\mathrm{c}\mathrm{e}},{\lambda }_{\mathrm{C}\mathrm{l}\mathrm{s}} $分别为对应损失项的权重;$ J $,$ K $分别为掩码图高度、宽度;$ {m}_{lj} $为第$ l $个实例的真实掩码图在第$ j $个像素的值;$ {\hat{m}}_{lj} $为第$ l $个实例的预测掩码图在第$ j $个像素的值;$ C $为类别总数;$ {w}_{c} $为类别$ c $的权重;$ {t}_{lc} $为第$ l $个实例在类别$ c $上的真实标签;$ {s}_{lc} $为模型预测的第$ l $个实例属于类别c的概率。

1.2 最优凸包搜寻定域模块

针对浮选泡沫边界难以精确划分的问题,本文将每个泡沫的完整边界分割任务转换为通过寻找目标泡沫周围相邻一圈泡沫质心所构成的凸包区域,并对凸包区域进行适当的缩放,以获取与实际泡沫边界更为接近的动态特征采样区域。这是由于:① 每个泡沫的边界均由周围邻近的多个泡沫共同作用产生,通过寻找紧邻目标泡沫的一圈泡沫质心,能有效捕捉邻近泡沫与目标泡沫在每个方向上的相互作用。② 凸包的几何属性决定了其内部是一个闭区域,找到一个相对最优的凸包后,便能划定一个完全封闭的动态特征采样区域。③ 利用凸包来近似泡沫边界,能够将原先复杂的泡沫边界简化为少量简单线段的组合,显著降低计算复杂度,并提高后续特征提取效率。

泡沫边界情况复杂多变,确保搜寻所得的凸包能尽可能拟合每个泡沫的真实轮廓是一个挑战。因此,最优凸包搜寻定域模块的核心在于设计最优凸包评价函数,通过对相邻质心所构成的多个凸包进行定量评价和筛选,以期自动搜寻到由目标泡沫周围邻近的一圈泡沫质心所构成的最优凸包。

设$ O $为目标泡沫的预测质心,$ {H} $为由$ {N}_{{H}} $个点组成的候选凸包,$ O $点必须位于凸包$ {H} $的内部。为评价候选凸包的优劣,定义一系列几何特征,并通过加权求和的形式构建最优凸包评价函数$ f\left({H}\right) $,具体过程如下。

1) 计算凸包$ {H} $的面积$ {S}_{ {H}} $。

$$ S_{ {H}}=\frac{1}{2}\left|\sum_{i=0}^{N_{{H}}-1}\left(x_i y_{i+1}-x_{i+1} y_i\right)\right| $$ (5) 式中$ ({x}_{i},{y}_{i}) $,$ ({x}_{i+1},{y}_{i+1}) $分别为凸包$ {H} $中第$ i,i+1 $个顶点的坐标。

2) 计算凸包$ {H} $的质心到目标泡沫预测质心$ O $点的距离$ {d}_{{O}{H}} $。

$$ d_{{OH}}=\sqrt{\left[x_O-\frac{1}{6 S_{ {H}}} \sum_{{i}=0}^{N_{{H}}-1}\left(x_i+x_{i+1}\right)\left(x_i y_{i+1}-x_{i+1} y_i\right)\right]^2+\left[y_O-\frac{1}{6 S_{ {H}}} \sum_{{i}=0}^{N_{{H}}-1}\left(y_i+y_{i+1}\right)\left(x_i y_{i+1}-x_{i+1} y_i\right)\right]^2} $$ (6) 式中$ ({x}_{O},{y}_{O}) $为目标泡沫预测质心$ O $点的坐标。

3) 计算凸包$ {H} $中各顶点到目标泡沫预测质心$ O $点的距离之和$ {d}_{{H}} $,其可反映凸包中顶点分布的整体情况。

$$ d_{{H}}=\sum_{i=0}^{N_{{H}}-1} \sqrt{\left(x_i-x_O\right)^2+\left(y_i-y_O\right)^2} $$ (7) 4) 计算凸包$ {H} $的内角方差$ {v}_{{H}} $,用于衡量凸包形状规整度。

$$ \begin{split} v_{{H}}=&\frac{1}{N_{{H}}} \sum_{i=1}^{N_{{H}}}\left(\arccos \frac{\overrightarrow{p_i p_{i+1}} \cdot \overrightarrow{p_{i+2} p_{i+1}}}{\left\|\overrightarrow{p_i p_{i+1}}\right\| \cdot\left\|\overrightarrow{p_{i+2} p_{i+1}}\right\|}-\right.\\ &\left. \frac{1}{N_{{H}}} \sum_{i=1}^{N_{{H}}} \arccos \frac{\overrightarrow{p_i p_{i+1}} \cdot \overrightarrow{p_{i+2} p_{i+1}}}{\left\|\overrightarrow{p_i p_{i+1}}\right\| \cdot\left\|\overrightarrow{p_{i+2} p_{i+1}}\right\|}\right)^2 \end{split} $$ (8) 式中$ {p}_{i}{,p}_{i+1}{,p}_{i+2} $分别为凸包$ {H} $中第$ i $,$ i+1 $,$ i $+2个顶点。

5) 最优凸包评价函数为

$$ \begin{split} f({H})=&w_1 \varphi\left(N_{{H}}\right)+w_2 \varphi\left(S_{ {H}}\right)-w_3 \varphi\left(d_{O {H}}\right)-\\ & w_4 \varphi\left(d_{{H}}\right)-w_5 \varphi\left(v_{{H}}\right) \end{split} $$ (9) 式中:$ {w}_{1} $—$ {w}_{5} $为不同特征项的权重;$ \varphi \left( \cdot \right) $为特征的归一化函数。

最优凸包评价函数的设计旨在通过关注凸包特定的几何属性,确保动态特征采样区域能准确地捕捉目标泡沫的边界特征。该评价函数设计要点:① 选择顶点数量更多的凸包,因为包含更多顶点的凸包能够更细致地拟合目标泡沫的边界,从而提升动态特征采样区域划定的精准度。② 最小化凸包内角方差,有助于保证凸包顶点均匀分布在目标泡沫质心周围,从而使动态特征采样区域形状更规整,避免因顶点分布不均导致的区域偏斜或失真。③ 最大化凸包面积,旨在覆盖更广泛的区域,以便捕获更加丰富的泡沫特征。④ 每个特征项有其独立的优化标准,且这些特征项之间存在一定的权衡关系,通过共同优化这些特征项,有效引导搜索最符合目标泡沫实际边界的动态特征采样区域。⑤ 为消除不同特征项之间的量纲差异,使用最大−最小归一化策略,且各特征项的权重可根据实际需求进行动态调整,以适应不同泡沫的复杂性。最优凸包搜寻定域模块伪代码如下。

算法1: 最优凸包搜寻定域

Input: 所有泡沫预测质心集合Z(去除所有较小泡沫类型的质心),目标泡沫的预测质心O点。

Output: 每个泡沫动态特征采样区域R。

1: 初始化空的最优凸包${H_{{\mathrm{opt}}}=\phi} $←对集合Z中所有质心与O点的欧氏距离进行排序,选择最近的NP个点构成候选点集P(需在边界描述精确性和计算效率之间灵活调整候选点集的数量);

2: for each 包含4个候选点以上的候选点子集$ {{Q} \subseteq {P}} $ do

/*构建凸包的迭代过程*/

3: 在子集Q中选择纵坐标y最小的点作为起始点Q0,若存在并列点,则选择横坐标x最小的点;

4: 对子集Q中除Q0外的其他点,按照与Q0点连线的斜率进行升序排序;

5: 初始化候选凸包$ {{H}= \phi} $;

6: for each 排序后的子集Q中的点Qi do

7: while候选凸包H最后3个点形成顺时针转向(叉积小于0) do

8: 从H中移除最后1个点;

9: end while

10: 若形成的转向为逆时针(叉积大于0),将Qi加入凸包H中;

11: end for

/*评估候选凸包H的有效性*/

12: if O点位于H内部且H内无其他外部点 then

13: 计算H最优凸包评价函数的得分;

14: if $ {f\left(H\right) > f\left({{H}}_{{\mathrm{opt}}}\right)} $ then

15: 更新最优凸包Hopt←H;

16: end if

17: end if

18: end for

19: 泡沫动态特征采样区域R←最优凸包Hopt中所有顶点至目标泡沫质心O点距离的二分位点所形成的封闭区域。

1.3 动态特征点对提取模块

在动态特征点对提取模块中,准确识别尽可能多的特征点对是关键。由于泡沫图像纹理特征不明显、背景单一,传统特征匹配方法在此情景下往往失效。本文采用LoFTR算法进行相邻帧间特征点对匹配,借鉴人类视觉的处理机制,通过结合自注意力和交叉注意力机制,获得全局感受野,实现像素级密集匹配,显著提高在低纹理、背景单一图像中的匹配效率。首先输入2帧相邻的泡沫图像,利用ResNet提取多尺度特征图,并将不同尺度特征图分别送入不同的分支进行处理,其中较低分辨率的特征图通过迭代应用自注意力和交叉注意力机制,每个点与其全局环境和相邻帧图像中的所有点建立联系,从而构建粗粒度匹配得分概率矩阵。然后利用相互最近邻(Mutual Nearest Neighbor,MNN)与置信度筛选机制,筛选出互为最高置信度匹配对,同时满足置信度阈值要求。粗粒度匹配的特征点对随后被映射回原始尺寸的特征图中,进而送入细粒度匹配模块再次进行自注意力和交叉注意力操作,以精确计算区域特征图中心点与对应点的相关性。最后通过概率分布求取期望值,获得相邻帧之间的特征点对坐标。

1.4 主特征自适应聚类模块

通过查找每个泡沫邻近的一圈泡沫质心而构建的泡沫边界,只是一种接近实际泡沫边界的有效近似,仍可能包含周围其他泡沫的区域。为了在每个划定的泡沫区域内部精准提取每个泡沫的主要流动速度,本文设计了基于OPTICS算法[19]的主特征自适应聚类模块,旨在通过聚类方法细化特征提取,获取数据的主要分布,从而更准确地描述每个泡沫的时空分布和动态特征。该模块首先将泡沫边界内所有特征点根据其距离和偏转角度进行聚类处理,OPTICS算法在此过程中通过为每个数据点计算核心距离和可达距离,构建一个反映数据点分布密度变化的排序列表。基于可达距离的排序结果揭示了不同密度区域的聚类结构,使得密度高的点在列表中聚集形成明显的聚类,而密度低的点则相对分散,从而明确聚类间的界限。在聚类结果的基础上,识别出包含数据点数量最多的主要聚类。然后,通过距离加权法计算动态特征采样区域内各个特征点与目标泡沫质心之间的距离,将其转换成对应的权值,并加权求和,最后计算出动态特征采样区域内最具代表性的泡沫流动速度。

2. 实验和结果

2.1 实验系统

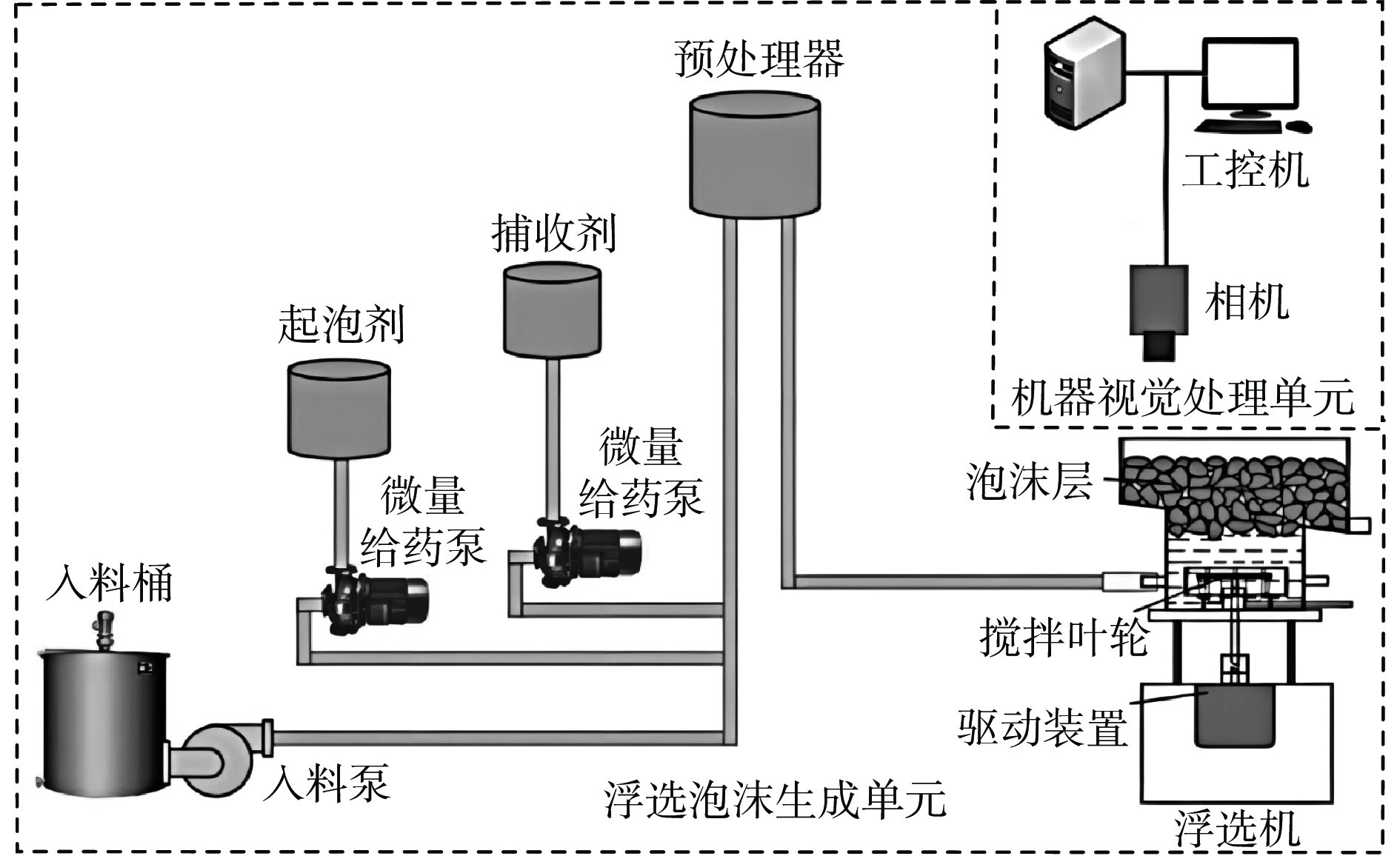

实验系统包括机器视觉处理单元与浮选泡沫生成单元,如图2所示。设计9组实验,模拟各种药剂配比、充气量大小及浓度梯度的变化工况。每组实验持续20~30 min,重复4~8次,视频记录以获取足量的不同工况下浮选泡沫图像样本,总计收集了770张高质量的泡沫图像和相应的关键帧视频片段。

2.2 定量分析实验结果

为验证泡沫质心分类定位与崩塌区域识别的有效性,将本文改进型Mask2Former算法与基于传统卷积神经网络(Convolutional Neural Networks,CNN)架构的算法(OCRNet[20],PSPNet[21],DeepLabV3+[22],CCNet[23])及基于Transformer架构的经典算法(Segmenter[24],SegFormer[25])进行对比,结果见表1。

表 1 不同算法在质心分类定位与崩塌区域识别任务的性能对比Table 1. Performance comparison of different algorithms in centroid classification positioning and collapse region identification tasks% 算法 普通泡沫质心 较小泡沫质心 不成泡区域 崩塌区域 交并比 准确率 交并比 准确率 交并比 准确率 交并比 准确率 OCRNet 61.02 67.36 45.92 54.07 87.22 89.81 84.58 87.59 PSPNet 72.46 82.16 54.19 64.32 91.41 95.42 87.27 91.69 DeepLabV3+ 71.22 81.07 55.33 69.89 90.20 94.09 88.05 93.19 CCNet 60.71 73.56 34.44 44.39 73.80 74.89 72.14 76.68 Segmenter 66.27 77.66 59.24 73.15 84.89 93.43 79.93 95.19 SegFormer 62.03 72.58 42.66 51.70 88.94 95.16 87.87 92.63 改进型Mask2Former 77.90 88.83 69.65 87.78 96.68 97.11 96.52 97.92 从表1可看出,改进型Mask2Former算法在所有类别上的表现均优于基于传统CNN架构的算法。这主要是由于基于传统CNN架构的算法在感受野和局部特征捕捉方面的固有局限性使其在整合全局上下文信息时表现不足,特别是在处理形状多样的泡沫图像时,细节识别能力不足,这在样本数量较少的不成泡区域和崩塌区域的识别任务中尤为明显。相比之下,改进型Mask2Former算法在不成泡区域和崩塌区域类型的识别中分别达到了96.68%和96.52%的交并比,这一优异表现可能归因于该算法通过解耦输出的方式实现了类别分类与区域预测任务的并行执行,从而能够在预测时直接估计大片区域,确保了区域边界预测准确和完整。此外,改进后的损失函数通过引入带权重机制,使得在损失计算中对少数类样本(如崩塌区域)给予更多关注,从而有效提升了算法对样本数量较少类别的学习能力。

与SegFormer和Segmenter这2种基于Transformer架构的算法相比,改进型Mask2Former算法的表现更加优异,特别是在较小泡沫质心的识别任务中,交并比和准确率分别达69.65%和87.78%,相较于SegFormer高出26.99%和36.08%,相较于Segmenter高出10.41%和14.63%。这可能是由于较小泡沫在图像中并不明显,而SegFormer和Segmenter由于其自注意力和交叉注意力计算量庞大,通常难以处理较高分辨率的图像,往往需要在较低分辨率的图像输入下进行处理,导致搜寻小泡沫质心时存在信息丢失。而改进型Mask2Former算法通过引入Swin−Transformer,在保证对全局信息整合能力的基础上,结合掩码注意力机制,不仅增强了对泡沫图像关键区域的聚焦能力,还能动态调整注意力范围,显著减少注意力操作的计算量,提高信息传递的效率。因此,该算法在处理高分辨率图像和小目标识别任务时表现尤为出色。

为评估动态特征点对提取时LoFTR算法的性能,与传统两阶段组合型特征点对匹配算法进行对比,传统算法即特征点检测算法(SIFT[26],SURF[27],AKAZE[11])结合匹配算法(FLANN[28],BF[29],RANSAC[30],ORB[31],GMS[32]),对比结果见表2。

表 2 不同算法下特征点对提取结果对比Table 2. Comparison of extraction results of feature point pairs under different algorithms算法 平均特征点检测数/个

(±标准差)平均错误点剔除数/个

(±标准差)平均剔除率/% 平均特征点最终匹配数/个

(±标准差)平均匹配正确率/%

(±标准差)SIFT+FLANN 1 669.37

(±303.41)803.12

(±214.20)48.11 866.25

(±355.23)98.35

(±0.47)SIFT+BF 461.63

(±82.65)27.65 1 207.75

(±278.69)78.80

(±10.11)SIFT+RANSAC 830.75

(±250.49)49.76 838.63

(±378.71)98.93

(±0.37)SURF+FLANN 2 131.88

(±166.28)990.38

(±278.63)46.46 1 141.5

(±373.15)99.40

(±0.44)SURF+BF 601.50

(±125.63)28.21 1 530.38

(±227.45)85.08

(±9.32)SURF+RANSAC 1049.75

(±273.11)49.24 1 082.12

(±376.68)99.02

(±0.36)AKAZE+BF 1 279.75

(±260.92)236.63

(±101.56)18.49 1 043.125

(±247.66)92.90

(±6.58)AKAZE+ORB 221.88

(±103.37)17.34 1 057.88

(±252.56)94.81

(±4.88)AKAZE+GMS 354.75

(±173.71)27.72 925.0

(±282.74)99.85

(±0.21)LoFTR 3 510.88

(±118.99)94.37

(±62.04)2.69 3 416.50

(±277.95)99.93

(±0.33)从表2可看出,LoFTR算法的平均特征点检测数相比于SIFT,SURF及AKAZE等传统算法分别提升了110%,65%与174%。这可能是由于在特征点检测阶段,传统算法依赖局部梯度、纹理和边缘信息提取关键点,在处理纹理单一且边界形状变化快的泡沫图像时,难以提取具有足够区分度的特征点,导致检测出的特征点数量较少,且稳定性差;在特征点对匹配阶段,传统算法依赖特征点描述符的相似性进行匹配,通常采用欧氏距离或汉明距离作为度量标准,然而这些描述符难以充分捕捉特征点之间的空间关系,特别是在纹理高度重复的泡沫图像中,易出现误匹配。此外,传统算法在特征点对匹配阶段容易产生大量无法找到匹配对的情况,这些无效的特征点往往需要在后处理阶段进行剔除,增加了计算复杂度并降低了匹配效率和准确率。LoFTR算法通过单帧图像内的自注意力和相邻图像间的交叉注意力,结合MNN过滤异常值,直接进行端到端的特征点对匹配,并采用由粗粒度至细粒度的特征点对匹配策略精确快速定位特征点,结合全局与局部特征信息,尤其在泡沫图像这种具有纹理单一且重复、边界形状快速变化的任务中,能有效捕获并匹配分布于整幅图像的相邻帧间特征点。在仅2.69%的平均剔除率下,LoFTR算法实现了高达99.93%的平均匹配正确率。

2.3 定性分析实验结果

由于泡沫图像采集装置安装在浮选机内部,处于高振动、高水雾、高粉尘的恶劣环境中,泡沫图像质量往往受到严重影响(如镜头失焦、模糊、过曝、积灰、积雾等),这些影响因素导致的图像质量下降对泡沫质心分类定位与崩塌区域识别模块的稳定性提出了更高要求。因此,对采集到的形态各异的泡沫图像进行破坏性风格迁移[33],生成多组低质量的泡沫图像。泡沫质心分类定位与崩塌区域识别模块在不同成像条件下的效果如图3所示,其中普通泡沫质心、较小泡沫质心、不成泡区域和崩塌区域分别以红色、绿色、紫色和黄色表示。可看出尽管经过破坏性风格迁移后的图像在细节上受到较大破坏(特别是在运动模糊和镜头积雾情境下),泡沫质心分类定位与崩塌区域识别模块依然能够稳定、精确地进行定位,表明该模块在恶劣环境下具有较强的鲁棒性。

传统的两阶段组合型特征点对匹配算法与LoFTR算法在不同泡沫形态下的特征点对匹配对比情况如图4所示。可看出传统算法因局部细节信息模糊和梯度不明显而出现大量漏检测及误匹配的情况;LoFTR算法在不同泡沫形态下始终表现稳定,检测匹配性能基本未受影响,有效检测并正确匹配的特征点能均匀分布于图像各区域(未检测到特征点区域均为实际崩塌区域)。这可能是由于LoFTR算法既通过CNN有效提取图像中的局部特征,又通过自注意力和交叉注意力操作与相邻帧图像间建立高效的信息交互,从而实现端到端的特征点对匹配,打破了传统算法局部特征描述与后匹配的限制,通过整合局部特征与全局上下文信息,即使在纹理贫乏、对比度低、图像模糊的条件下也能实现高质量的特征点对密集匹配。

最优凸包搜寻定域模块输出的泡沫动态特征采样区域如图5所示。图5(a)展示了普通泡沫(红色)、崩塌区域(青色)在空间中的位置及每个泡沫的动态特征采样区域(用灰色填充);图5(b)展示了12个局部泡沫凸包定域过程细节,其中红点代表泡沫质心,黄线代表由邻近目标泡沫质心周围一圈泡沫质心所构成的最能代表目标泡沫轮廓形状的最优凸包,黑线代表最优凸包通过特定的缩放比例所确定的目标泡沫动态特征采样区域轮廓。从图5可看出,最优凸包搜寻定域模块在无需精确边缘分割的情况下,利用泡沫的几何和相互作用特性,能够划定与实际泡沫边界近似相符的特征采样区域。

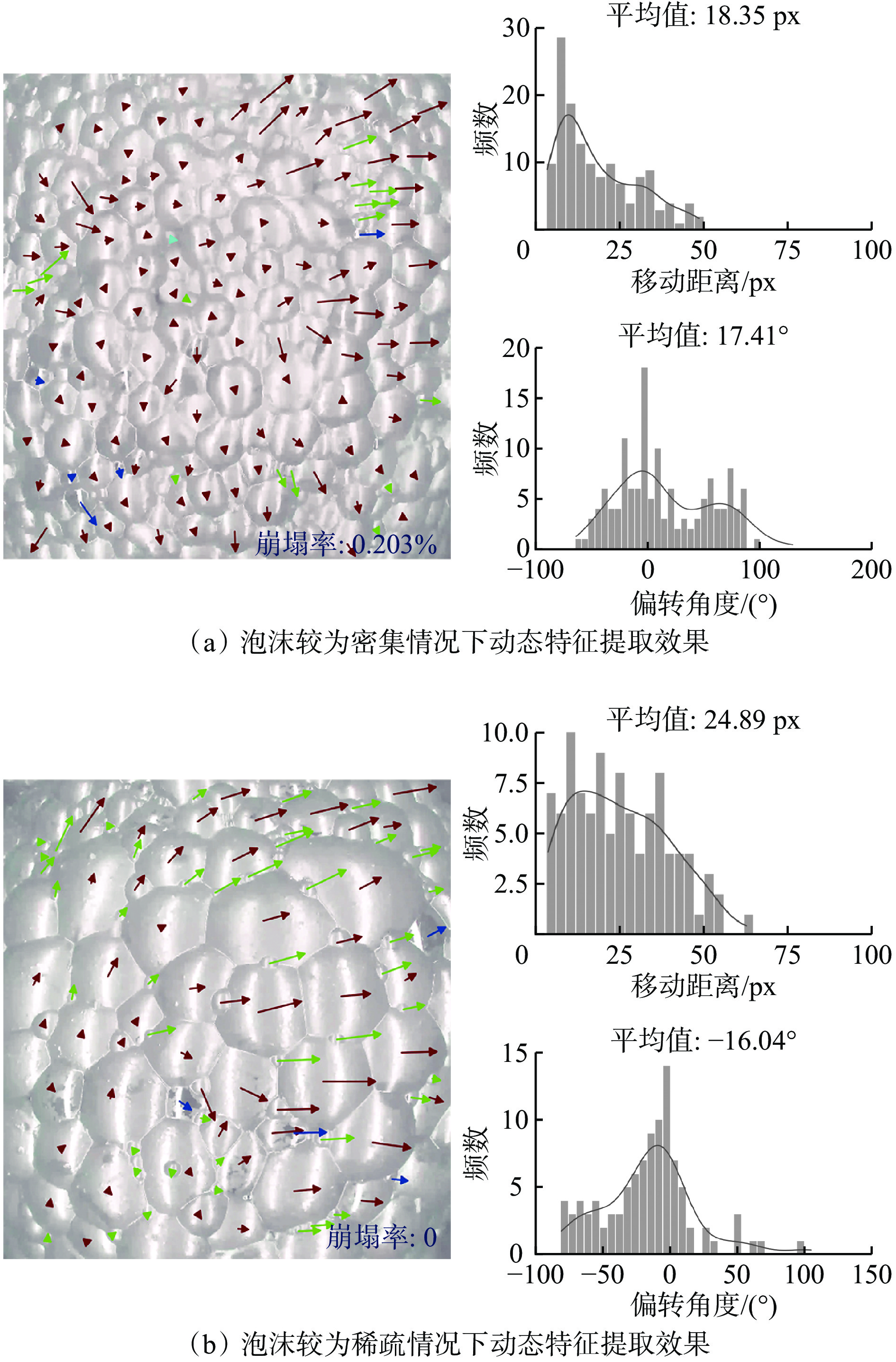

2种常见泡沫形态图像通过基于质心−凸包−自适应聚类法的浮选泡沫动态特征提取方法所获取的泡沫流动速度场如图6所示。图中箭头指向代表泡沫的偏转角度,箭头长度代表相邻帧间泡沫流动的距离,箭头颜色表示不同的泡沫类型(红色为普通泡沫,绿色为较小泡沫,青色为崩塌区域)。可看出该方法可有效量化提取的浮选泡沫动态特征,为浮选过程实时状态的监测与评估提供稳定可靠的数据基础。

3. 结论

1) 提出了一种基于质心−凸包−自适应聚类法的浮选泡沫动态特征提取方法。该方法通过Swin−Transformer精准定位泡沫质心,并利用最优凸包评价函数在相邻质心之间构建凸包区域,划定与实际泡沫轮廓接近的动态特征采样区域;引入LoFTR算法,通过结合自注意力与交叉注意力机制,增强了特征点对匹配的稳定性和准确性;采用主特征自适应聚类法,在划定的动态特征采样区域内,通过密度聚类和距离加权的方式,准确提取每个泡沫的主要流动速度,降低了噪声对动态特征提取的影响。

2) 实验结果表明,该方法在不同类型泡沫质心定位及崩塌区域识别上的准确率较高,以仅2.69%的平均剔除率实现了99.93%的特征点对匹配正确率,能够划定与实际泡沫边界近似相符的动态特征采样区域,提高了复杂工况下泡沫动态特征的提取精度。

-

表 1 不同算法在质心分类定位与崩塌区域识别任务的性能对比

Table 1 Performance comparison of different algorithms in centroid classification positioning and collapse region identification tasks

% 算法 普通泡沫质心 较小泡沫质心 不成泡区域 崩塌区域 交并比 准确率 交并比 准确率 交并比 准确率 交并比 准确率 OCRNet 61.02 67.36 45.92 54.07 87.22 89.81 84.58 87.59 PSPNet 72.46 82.16 54.19 64.32 91.41 95.42 87.27 91.69 DeepLabV3+ 71.22 81.07 55.33 69.89 90.20 94.09 88.05 93.19 CCNet 60.71 73.56 34.44 44.39 73.80 74.89 72.14 76.68 Segmenter 66.27 77.66 59.24 73.15 84.89 93.43 79.93 95.19 SegFormer 62.03 72.58 42.66 51.70 88.94 95.16 87.87 92.63 改进型Mask2Former 77.90 88.83 69.65 87.78 96.68 97.11 96.52 97.92 表 2 不同算法下特征点对提取结果对比

Table 2 Comparison of extraction results of feature point pairs under different algorithms

算法 平均特征点检测数/个

(±标准差)平均错误点剔除数/个

(±标准差)平均剔除率/% 平均特征点最终匹配数/个

(±标准差)平均匹配正确率/%

(±标准差)SIFT+FLANN 1 669.37

(±303.41)803.12

(±214.20)48.11 866.25

(±355.23)98.35

(±0.47)SIFT+BF 461.63

(±82.65)27.65 1 207.75

(±278.69)78.80

(±10.11)SIFT+RANSAC 830.75

(±250.49)49.76 838.63

(±378.71)98.93

(±0.37)SURF+FLANN 2 131.88

(±166.28)990.38

(±278.63)46.46 1 141.5

(±373.15)99.40

(±0.44)SURF+BF 601.50

(±125.63)28.21 1 530.38

(±227.45)85.08

(±9.32)SURF+RANSAC 1049.75

(±273.11)49.24 1 082.12

(±376.68)99.02

(±0.36)AKAZE+BF 1 279.75

(±260.92)236.63

(±101.56)18.49 1 043.125

(±247.66)92.90

(±6.58)AKAZE+ORB 221.88

(±103.37)17.34 1 057.88

(±252.56)94.81

(±4.88)AKAZE+GMS 354.75

(±173.71)27.72 925.0

(±282.74)99.85

(±0.21)LoFTR 3 510.88

(±118.99)94.37

(±62.04)2.69 3 416.50

(±277.95)99.93

(±0.33) -

[1] 王然风,高建川,付翔. 智能化选煤厂架构及关键技术[J]. 工矿自动化,2019,45(7):28-32. WANG Ranfeng,GAO Jianchuan,FU Xiang. Framework and key technologies of intelligent coal preparation plant[J]. Industry and Mine Automation,2019,45(7):28-32.

[2] POPLI K,SEKHAVAT M,AFACAN A,et al. Dynamic modeling and real-time monitoring of froth flotation[J]. Minerals,2015,5(3):570-591. DOI: 10.3390/min5030510

[3] 赵洪伟,谢永芳,蒋朝辉,等. 基于泡沫图像特征的浮选槽液位智能优化设定方法[J]. 自动化学报,2014,40(6):1086-1097. ZHAO Hongwei,XIE Yongfang,JIANG Zhaohui,et al. An intelligent optimal setting approach based on froth features for level of flotation cells[J]. Acta Automatica Sinica,2014,40(6):1086-1097.

[4] MOOLMAN D W,EKSTEEN J J,ALDRICH C,et al. The significance of flotation froth appearance for machine vision control[J]. International Journal of Mineral Processing,1996,48(3/4):135-158.

[5] NEETHLING S J,BRITO-PARADA P R. Predicting flotation behaviour-the interaction between froth stability and performance[J]. Minerals Engineering,2018,120:60-65. DOI: 10.1016/j.mineng.2018.02.002

[6] ALDRICH C,MARAIS C,SHEAN B J,et al. Online monitoring and control of froth flotation systems with machine vision:a review[J]. International Journal of Mineral Processing,2010,96(1/2/3/4):1-13.

[7] 阳春华,杨尽英,牟学民,等. 基于聚类预分割和高低精度距离重构的彩色浮选泡沫图像分割[J]. 电子与信息学报,2008,30(6):1286-1290. YANG Chunhua,YANG Jinying,MU Xuemin,et al. A segmentation method based on clustering pre-segmentation and high-low scale distance reconstruction for colour froth image[J]. Journal of Electronics & Information Technology,2008,30(6):1286-1290.

[8] 李建奇. 矿物浮选泡沫图像增强与分割方法研究及应用[D]. 长沙:中南大学,2013. LI Jianqi. Froth image enhancement and segmentation method and its application for mineral flotation[D]. Changsha:Central South University,2013.

[9] 唐朝晖,郭俊岑,张虎,等. 基于改进I−Attention U−Net的锌浮选泡沫图像分割算法[J]. 湖南大学学报(自然科学版),2023,50(2):12-22. TANG Zhaohui,GUO Juncen,ZHANG Hu,et al. Froth image segmentation algorithm based on improved I-Attention U-Net for zinc flotation[J]. Journal of Hunan University (Natural Sciences),2023,50(2):12-22.

[10] 牟学民,刘金平,桂卫华,等. 基于SIFT特征配准的浮选泡沫移动速度提取与分析[J]. 信息与控制,2011,40(4):525-531. MU Xuemin,LIU Jinping,GUI Weihua,et al. Flotation froth motion velocity extraction and analysis based on SIFT features registration[J]. Information and Control,2011,40(4):525-531.

[11] 郭中天,王然风,付翔,等. 基于图像特征匹配的煤泥浮选泡沫速度特征提取方法[J]. 工矿自动化,2022,48(10):34-39,54. GUO Zhongtian,WANG Ranfeng,FU Xiang,et al. Method for extracting froth velocity of coal slime flotation based on image feature matching[J]. Journal of Mine Automation,2022,48(10):34-39,54.

[12] 唐朝晖,刘金平,桂卫华,等. 基于数字图像处理的浮选泡沫速度特征提取及分析[J]. 中南大学学报(自然科学版),2009,40(6):1616-1622. TANG Zhaohui,LIU Jinping,GUI Weihua,et al. Froth bubbles speed characteristic extraction and analysis based on digital image processing[J]. Journal of Central South University (Science and Technology),2009,40(6):1616-1622.

[13] JAHEDSARAVANI A,MARHABAN M H,MASSINAEI M. Prediction of the metallurgical performances of a batch flotation system by image analysis and neural networks[J]. Minerals Engineering,2014,69:137-145. DOI: 10.1016/j.mineng.2014.08.003

[14] MORAR S H,BRADSHAW D J,HARRIS M C. The use of the froth surface lamellae burst rate as a flotation froth stability measurement[J]. Minerals Engineering,2012,36:152-159.

[15] LIU Ze,LIN Yutong,CAO Yue,et al. Swin transformer:hierarchical vision transformer using shifted windows[C]. IEEE/CVF International Conference on Computer Vision,Montreal,2021:10012-10022.

[16] CHENG Bowen,MISRA I,SCHWING A G,et al. Masked-attention mask transformer for universal image segmentation[C]. IEEE/CVF Conference on Computer Vision and Pattern Recognition,New Orleans,2022:1290-1299.

[17] KIRILLOV A,WU Yuxin,HE Kaiming,et al. PointRend:image segmentation as rendering[C]. IEEE/CVF Conference on Computer Vision and Pattern Recognition,Seattle,2020:9796-9805.

[18] SUN Jiaming,SHEN Zehong,WANG Yu'ang,et al. LoFTR:detector-free local feature matching with transformers[C]. IEEE/CVF Conference on Computer Vision and Pattern Recognition,Nashville,2021:8918-8927.

[19] ANKERST M,BREUNIG M M,KRIEGEL H P,et al. OPTICS:ordering points to identify the clustering structure[J]. ACM Sigmod Record,1999,28(2):49-60. DOI: 10.1145/304181.304187

[20] YUAN Yuhui,CHEN Xilin,WANG Jingdong. Object-contextual representations for semantic segmentation[C]. European Conference on Computer Vision,Glasgow,2020:173-190.

[21] ZHAO Hengshuang,SHI Jianping,QI Xiaojuan,et al. Pyramid scene parsing network[C]. IEEE Conference on Computer Vision and Pattern Recognition,Honolulu,2017:6230-6239.

[22] CHEN L C,ZHU Yukun,PAPANDREOU G,et al. Encoder-decoder with atrous separable convolution for semantic image segmentation[C]. European Conference on Computer Vision,Munich,2018:801-818.

[23] HUANG Zilong,WANG Xinggang,HUANG Lichao,et al. CCNet:criss-cross attention for semantic segmentation[C]. IEEE/CVF International Conference on Computer Vision,Seoul,2019:603-612.

[24] STRUDEL R,GARCIA R,LAPTEV I,et al. Segmenter:transformer for semantic segmentation[C]. IEEE/CVF International Conference on Computer Vision,Montreal,2021:7242-7252.

[25] XIE Enze,WANG Wenhai,YU Zhiding,et al. SegFormer:simple and efficient design for semantic segmentation with transformers[C]. Conference and Workshop on Neural Information Processing Systems,2021:12077-12090.

[26] LOWE D G. Distinctive image features from scale-invariant keypoints[J]. International Journal of Computer Vision,2004,60(2):91-110. DOI: 10.1023/B:VISI.0000029664.99615.94

[27] BAY H,ESS A,TUYTELAARS T,et al. Speeded-up robust features (SURF)[J]. Computer Vision and Image Understanding,2008,110(3):346-359. DOI: 10.1016/j.cviu.2007.09.014

[28] MUJA M,LOWE D G. Fast approximate nearest neighbors with automatic algorithm configuration[C]. The 4th International Conference on Computer Vision Theory and Applications,Lisboa,2009:331-340.

[29] OI L,LIU Wei,LIU Ding. ORB-based fast anti-viewing image feature matching algorithm[C]. Chinese Automation Congress,Xi'an,2018:2402-2406.

[30] FISCHLER M A,BOLLES R C. Random sample consensus:a paradigm for model fitting with applications to image analysis and automated cartography[J]. Communications of the ACM,1981,24(6):381-395. DOI: 10.1145/358669.358692

[31] RUBLEE E,RABAUD V,KONOLIGE K,et al. ORB:an efficient alternative to SIFT or SURF[C]. International Conference on Computer Vision,Barcelona,2011:2564-2571.

[32] BIAN Jiawang,LIN Wenyan,LIU Yun,et al. GMS:grid-based motion statistics for fast,ultra-robust feature correspondence[J]. International Journal of Computer Vision,2020,128(6):1580-1593. DOI: 10.1007/s11263-019-01280-3

[33] MICHAELIS C,MITZKUS B,GEIRHOS R,et al. Benchmarking robustness in object detection:autonomous driving when winter is coming[EB/OL]. [2024-02-25]. https://arxiv.org/abs/1907.07484v2.

下载:

下载: